MiniBatchDictionaryLearning#

- класс sklearn.decomposition.MiniBatchDictionaryLearning(n_components=None, *, alpha=1, max_iter=1000, fit_algorithm='lars', n_jobs=None, batch_size=256, перемешивание=True, dict_init=None, transform_algorithm='omp', transform_n_nonzero_coefs=None, transform_alpha=None, verbose=False, split_sign=False, random_state=None, positive_code=False, positive_dict=False, transform_max_iter=1000, callback=None, tol=0.001, max_no_improvement=10)[источник]#

Мини-пакетное словарное обучение.

Находит словарь (набор атомов), который хорошо работает для разреженного кодирования подогнанных данных.

Решает задачу оптимизации:

(U^*,V^*) = argmin 0.5 || X - U V ||_Fro^2 + alpha * || U ||_1,1 (U,V) with || V_k ||_2 <= 1 for all 0 <= k < n_components

||.||_Fro обозначает норму Фробениуса, а ||.||_1,1 обозначает поэлементную матричную норму, которая является суммой абсолютных значений всех элементов матрицы.

Подробнее в Руководство пользователя.

- Параметры:

- n_componentsint, default=None

Количество элементов словаря для извлечения.

- alphafloat, по умолчанию=1

Параметр управления разреженностью.

- max_iterint, по умолчанию=1_000

Максимальное количество итераций по полному набору данных перед остановкой независимо от любых эвристик критерия ранней остановки.

Добавлено в версии 1.1.

- fit_algorithm{‘lars’, ‘cd’}, default=’lars’

Используемый алгоритм:

'lars': использует метод наименьшего угла регрессии для решения задачи лассо (linear_model.lars_path)'cd': использует метод координатного спуска для вычисления решения Lasso (linear_model.Lasso). Lars будет быстрее, если оцененные компоненты разрежены.

- n_jobsint, default=None

Количество параллельных задач для выполнения.

Noneозначает 1, если только не вjoblib.parallel_backendконтекст.-1означает использование всех процессоров. См. Глоссарий для получения дополнительной информации.- batch_sizeint, по умолчанию=256

Количество образцов в каждой мини-партии.

Изменено в версии 1.3: Значение по умолчанию для

batch_sizeизменено с 3 на 256 в версии 1.3.- перемешиваниеbool, по умолчанию=True

Перемешивать ли образцы перед формированием батчей.

- dict_initndarray формы (n_components, n_features), default=None

Начальное значение словаря для сценариев теплого перезапуска.

- transform_algorithm{‘lasso_lars’, ‘lasso_cd’, ‘lars’, ‘omp’, ‘threshold’}, по умолчанию=’omp’

Алгоритм, используемый для преобразования данных:

'lars': использует метод наименьшего угла регрессии (linear_model.lars_path);'lasso_lars': использует Lars для вычисления решения Lasso.'lasso_cd': использует метод координатного спуска для вычисления решения Lasso (linear_model.Lasso).'lasso_lars'будет быстрее если оцененные компоненты разрежены.'omp': использует ортогональный жадный поиск для оценки разреженного решения.'threshold': обнуляет все коэффициенты меньше alpha из проекцииdictionary * X'.

- transform_n_nonzero_coefsint, default=None

Количество ненулевых коэффициентов для целевого значения в каждом столбце решения. Используется только

algorithm='lars'иalgorithm='omp'. ЕслиNone, затемtransform_n_nonzero_coefs=int(n_features / 10).- transform_alphafloat, по умолчанию=None

Если

algorithm='lasso_lars'илиalgorithm='lasso_cd',alphaявляется штрафом, применяемым к норме L1. Еслиalgorithm='threshold',alphaявляется абсолютным значением порога, ниже которого коэффициенты будут сжаты до нуля. ЕслиNone, по умолчаниюalpha.Изменено в версии 1.2: Когда None, значение по умолчанию изменено с 1.0 на

alpha.- verbosebool или int, по умолчанию=False

Для управления подробностью процедуры.

- split_signbool, по умолчанию=False

Разделять ли разреженный вектор признаков на конкатенацию его отрицательной части и его положительной части. Это может улучшить производительность последующих классификаторов.

- random_stateint, экземпляр RandomState или None, по умолчанию=None

Используется для инициализации словаря, когда

dict_initне указан, случайное перемешивание данных, когдаshuffleустановлено вTrue, и обновление словаря. Передайте int для воспроизводимых результатов при нескольких вызовах функции. См. Глоссарий.- positive_codebool, по умолчанию=False

Следует ли обеспечивать положительность при нахождении кода.

Добавлено в версии 0.20.

- positive_dictbool, по умолчанию=False

Следует ли обеспечивать положительность при поиске словаря.

Добавлено в версии 0.20.

- transform_max_iterint, по умолчанию=1000

Максимальное количество итераций для выполнения, если

algorithm='lasso_cd'или'lasso_lars'.Добавлено в версии 0.22.

- callbackвызываемый объект, по умолчанию=None

Вызываемый объект, который вызывается в конце каждой итерации.

Добавлено в версии 1.1.

- tolfloat, по умолчанию=1e-3

Управление ранней остановкой на основе нормы различий в словаре между 2 шагами.

Чтобы отключить раннюю остановку на основе изменений в словаре, установите

tolдо 0.0.Добавлено в версии 1.1.

- max_no_improvementint, по умолчанию=10

Контроль ранней остановки на основе последовательного количества мини-батчей, которые не дают улучшения сглаженной функции стоимости.

Чтобы отключить обнаружение сходимости на основе функции стоимости, установите

max_no_improvementв None.Добавлено в версии 1.1.

- Атрибуты:

- components_ndarray формы (n_components, n_features)

Компоненты, извлеченные из данных.

- n_features_in_int

Количество признаков, замеченных во время fit.

Добавлено в версии 0.24.

- feature_names_in_ndarray формы (

n_features_in_,) Имена признаков, наблюдаемых во время fit. Определено только когда

Xимеет имена признаков, которые все являются строками.Добавлено в версии 1.0.

- n_iter_int

Количество итераций по полному набору данных.

- n_steps_int

Количество обработанных мини-пакетов.

Добавлено в версии 1.1.

Смотрите также

DictionaryLearningНайти словарь, который разреженно кодирует данные.

MiniBatchSparsePCAМини-пакетный разреженный анализ главных компонент.

SparseCoderНайти разреженное представление данных из фиксированного, предварительно вычисленного словаря.

SparsePCAРазреженный анализ главных компонент.

Ссылки

J. Mairal, F. Bach, J. Ponce, G. Sapiro, 2009: Онлайн-обучение словаря для разреженного кодирования (https://www.di.ens.fr/~fbach/mairal_icml09.pdf)

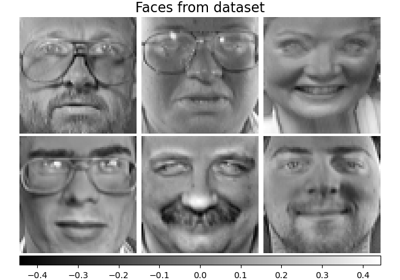

Примеры

>>> import numpy as np >>> from sklearn.datasets import make_sparse_coded_signal >>> from sklearn.decomposition import MiniBatchDictionaryLearning >>> X, dictionary, code = make_sparse_coded_signal( ... n_samples=30, n_components=15, n_features=20, n_nonzero_coefs=10, ... random_state=42) >>> dict_learner = MiniBatchDictionaryLearning( ... n_components=15, batch_size=3, transform_algorithm='lasso_lars', ... transform_alpha=0.1, max_iter=20, random_state=42) >>> X_transformed = dict_learner.fit_transform(X)

Мы можем проверить уровень разреженности

X_transformed:>>> np.mean(X_transformed == 0) > 0.5 np.True_

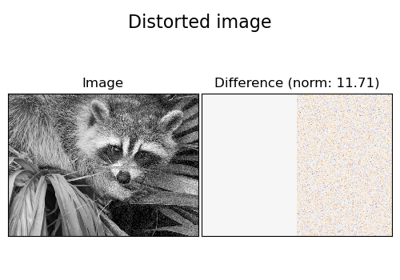

Мы можем сравнить среднюю квадратичную евклидову норму ошибки реконструкции разреженно закодированного сигнала относительно квадратичной евклидовой нормы исходного сигнала:

>>> X_hat = X_transformed @ dict_learner.components_ >>> np.mean(np.sum((X_hat - X) ** 2, axis=1) / np.sum(X ** 2, axis=1)) np.float64(0.052)

Для более подробного примера см. Удаление шума изображений с использованием обучения словаря

- fit(X, y=None)[источник]#

Обучить модель на данных из X.

- Параметры:

- Xarray-like формы (n_samples, n_features)

Вектор обучения, где

n_samplesэто количество образцов иn_featuresэто количество признаков.- yИгнорируется

Не используется, присутствует для согласованности API по соглашению.

- Возвращает:

- selfobject

Возвращает сам экземпляр.

- fit_transform(X, y=None, **fit_params)[источник]#

Обучение на данных с последующим преобразованием.

Обучает преобразователь на

Xиyс необязательными параметрамиfit_paramsи возвращает преобразованную версиюX.- Параметры:

- Xarray-like формы (n_samples, n_features)

Входные выборки.

- yarray-like формы (n_samples,) или (n_samples, n_outputs), default=None

Целевые значения (None для неконтролируемых преобразований).

- **fit_paramsdict

Дополнительные параметры обучения. Передавайте только если оценщик принимает дополнительные параметры в своем

fitметод.

- Возвращает:

- X_newndarray массив формы (n_samples, n_features_new)

Преобразованный массив.

- get_feature_names_out(input_features=None)[источник]#

Получить имена выходных признаков для преобразования.

Имена признаков на выходе будут иметь префикс в виде имени класса в нижнем регистре. Например, если преобразователь выводит 3 признака, то имена признаков на выходе:

["class_name0", "class_name1", "class_name2"].- Параметры:

- input_featuresarray-like из str или None, по умолчанию=None

Используется только для проверки имен признаков с именами, встреченными в

fit.

- Возвращает:

- feature_names_outndarray из str объектов

Преобразованные имена признаков.

- 6332()[источник]#

Получить маршрутизацию метаданных этого объекта.

Пожалуйста, проверьте Руководство пользователя о том, как работает механизм маршрутизации.

- Возвращает:

- маршрутизацияMetadataRequest

A

MetadataRequestИнкапсуляция информации о маршрутизации.

- get_params(глубокий=True)[источник]#

Получить параметры для этого оценщика.

- Параметры:

- глубокийbool, по умолчанию=True

Если True, вернет параметры для этого оценщика и вложенных подобъектов, которые являются оценщиками.

- Возвращает:

- paramsdict

Имена параметров, сопоставленные с их значениями.

- inverse_transform(X)[источник]#

Преобразование данных обратно в исходное пространство.

- Параметры:

- Xarray-like формы (n_samples, n_components)

Данные для обратного преобразования. Должны иметь то же количество компонентов, что и данные, использованные для обучения модели.

- Возвращает:

- X_originalndarray формы (n_samples, n_features)

Преобразованные данные.

- partial_fit(X, y=None)[источник]#

Обновление модели с использованием данных в X как мини-пакета.

- Параметры:

- Xarray-like формы (n_samples, n_features)

Вектор обучения, где

n_samplesэто количество образцов иn_featuresэто количество признаков.- yИгнорируется

Не используется, присутствует для согласованности API по соглашению.

- Возвращает:

- selfobject

Возвращает сам экземпляр.

- set_output(*, преобразовать=None)[источник]#

Установить контейнер вывода.

См. Введение API set_output для примера использования API.

- Параметры:

- преобразовать{“default”, “pandas”, “polars”}, по умолчанию=None

Настройка вывода

transformиfit_transform."default": Формат вывода трансформера по умолчанию"pandas": DataFrame вывод"polars": Вывод PolarsNone: Конфигурация преобразования не изменена

Добавлено в версии 1.4:

"polars"опция была добавлена.

- Возвращает:

- selfэкземпляр estimator

Экземпляр оценщика.

- set_params(**params)[источник]#

Установить параметры этого оценщика.

Метод работает как на простых оценщиках, так и на вложенных объектах (таких как

Pipeline). Последние имеют параметры вида__ - Параметры:

- **paramsdict

Параметры оценщика.

- Возвращает:

- selfэкземпляр estimator

Экземпляр оценщика.

- преобразовать(X)[источник]#

Закодируйте данные как разреженную комбинацию атомов словаря.

Метод кодирования определяется параметром объекта

transform_algorithm.- Параметры:

- Xndarray формы (n_samples, n_features)

Тестовые данные для преобразования, должны иметь то же количество признаков, что и данные, использованные для обучения модели.

- Возвращает:

- X_newndarray формы (n_samples, n_components)

Преобразованные данные.

Примеры галереи#

Удаление шума изображений с использованием обучения словаря