f1_score#

- sklearn.metrics.f1_score(y_true, y_pred, *, метки=None, pos_label=1, среднее='binary', sample_weight=None, zero_division='warn')[источник]#

Вычислите оценку F1, также известную как сбалансированная F-оценка или F-мера.

Оценка F1 может быть интерпретирована как гармоническое среднее точности и полноты, где оценка F1 достигает своего наилучшего значения при 1 и худшего при 0. Относительный вклад точности и полноты в оценку F1 одинаков. Формула для оценки F1:

\[\text{F1} = \frac{2 * \text{TP}}{2 * \text{TP} + \text{FP} + \text{FN}}\]Где \(\text{TP}\) это количество истинно положительных случаев, \(\text{FN}\) — это количество ложноотрицательных результатов, а \(\text{FP}\) — это количество ложных срабатываний. F1 по умолчанию рассчитывается как 0.0, когда нет истинных срабатываний, ложных отрицаний или ложных срабатываний.

Поддержка за пределами бинарный целей достигается путем обработки многоклассовый и многометочный данные как набор бинарных задач, по одной для каждой метки. Для бинарный случае, установка

average='binary'будет возвращать F1-оценку дляpos_label. Еслиaverageне является'binary',pos_labelигнорируется и F1-оценка для обоих классов вычисляется, затем усредняется или возвращается обе (когдаaverage=None). Аналогично, для многоклассовый и многометочный целевые значения, F1-мера для всехlabelsлибо возвращаются, либо усредняются в зависимости отaverageпараметр. Используйтеlabelsуказать набор меток для расчета F1-оценки.Подробнее в Руководство пользователя.

- Параметры:

- y_true1d array-like, или массив индикаторов меток / разреженная матрица

Истинные (правильные) целевые значения. Разреженная матрица поддерживается только когда цели имеют многометочный тип.

- y_pred1d array-like, или массив индикаторов меток / разреженная матрица

Оцененные цели, возвращаемые классификатором. Разреженная матрица поддерживается только когда цели имеют многометочный тип.

- меткиarray-like, default=None

Набор меток для включения, когда

average != 'binary', и их порядок, еслиaverage is None. Метки, присутствующие в данных, могут быть исключены, например, в многоклассовой классификации для исключения "отрицательного класса". Метки, отсутствующие в данных, могут быть включены и им будет "назначено" 0 образцов. Для многометочных целей метки являются индексами столбцов. По умолчанию все метки вy_trueиy_predиспользуются в отсортированном порядке.Изменено в версии 0.17: Параметр

labelsулучшена для многоклассовой задачи.- pos_labelint, float, bool или str, по умолчанию=1

Класс для отчета, если

average='binary'и данные являются бинарными, в противном случае этот параметр игнорируется. Для многоклассовых или многометочных целей, установитеlabels=[pos_label]иaverage != 'binary'для отчета метрик только для одной метки.- среднее{‘micro’, ‘macro’, ‘samples’, ‘weighted’, ‘binary’} или None, по умолчанию=’binary’

Этот параметр обязателен для многоклассовых/многометочных целей. Если

None, метрики для каждого класса возвращаются. В противном случае это определяет тип усреднения, выполняемого над данными:'binary':Отчитываться только о результатах для класса, указанного

pos_label. Это применимо только если цели (y_{true,pred}) являются бинарными.'micro':Рассчитать метрики глобально, подсчитывая общее количество истинно положительных, ложно отрицательных и ложноположительных.

'macro':Вычислить метрики для каждой метки и найти их невзвешенное среднее. Это не учитывает дисбаланс меток.

'weighted':Вычисляет метрики для каждой метки и находит их среднее, взвешенное по поддержке (количеству истинных экземпляров для каждой метки). Это изменяет 'macro' для учёта дисбаланса меток; может привести к F-оценке, не находящейся между точностью и полнотой.

'samples':Вычислить метрики для каждого экземпляра и найти их среднее (имеет смысл только для многоклассовой классификации, где это отличается от

accuracy_score).

- sample_weightarray-like формы (n_samples,), по умолчанию=None

Веса выборок.

- zero_division{"warn", 0.0, 1.0, np.nan}, по умолчанию="warn"

Устанавливает значение, возвращаемое при делении на ноль, т.е. когда все прогнозы и метки отрицательные.

Примечания: - Если установлено "warn", это действует как 0, но также выдается предупреждение. - Если установлено

np.nan, такие значения будут исключены из среднего.Добавлено в версии 1.3:

np.nanопция была добавлена.

- Возвращает:

- f1_scorefloat или массив float, shape = [n_unique_labels]

F1-мера положительного класса в бинарной классификации или взвешенное среднее F1-мер каждого класса для многоклассовой задачи.

Смотрите также

fbeta_scoreВычислить F-бета оценку.

precision_recall_fscore_supportВычислить точность, полноту, F-меру и поддержку.

jaccard_scoreВычисляет коэффициент сходства Жаккара.

multilabel_confusion_matrixВычислить матрицу ошибок для каждого класса или образца.

Примечания

Когда

true positive + false positive + false negative == 0(т.е. класс полностью отсутствует в обоихy_trueилиy_pred), F-оценка не определена. В таких случаях по умолчанию F-оценка будет установлена в 0.0, иUndefinedMetricWarningбудет вызвано. Это поведение можно изменить, установивzero_divisionпараметр.Ссылки

Примеры

>>> import numpy as np >>> from sklearn.metrics import f1_score >>> y_true = [0, 1, 2, 0, 1, 2] >>> y_pred = [0, 2, 1, 0, 0, 1] >>> f1_score(y_true, y_pred, average='macro') 0.267 >>> f1_score(y_true, y_pred, average='micro') 0.33 >>> f1_score(y_true, y_pred, average='weighted') 0.267 >>> f1_score(y_true, y_pred, average=None) array([0.8, 0. , 0. ])

>>> # binary classification >>> y_true_empty = [0, 0, 0, 0, 0, 0] >>> y_pred_empty = [0, 0, 0, 0, 0, 0] >>> f1_score(y_true_empty, y_pred_empty) 0.0... >>> f1_score(y_true_empty, y_pred_empty, zero_division=1.0) 1.0... >>> f1_score(y_true_empty, y_pred_empty, zero_division=np.nan) nan...

>>> # multilabel classification >>> y_true = [[0, 0, 0], [1, 1, 1], [0, 1, 1]] >>> y_pred = [[0, 0, 0], [1, 1, 1], [1, 1, 0]] >>> f1_score(y_true, y_pred, average=None) array([0.66666667, 1. , 0.66666667])

Примеры галереи#

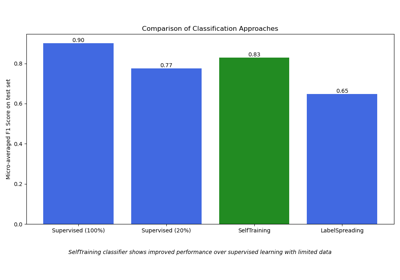

Полу-контролируемая классификация на текстовом наборе данных