Примечание

Перейти в конец чтобы скачать полный пример кода или запустить этот пример в браузере через JupyterLite или Binder.

Робастная vs эмпирическая оценка ковариации#

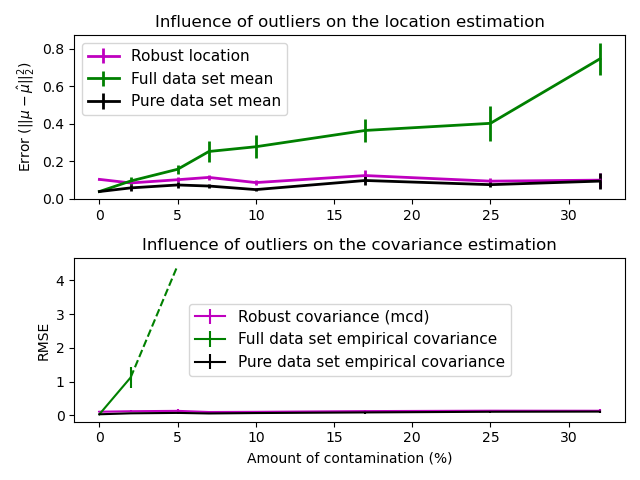

Обычная оценка максимального правдоподобия для ковариации очень чувствительна к наличию выбросов в наборе данных. В таком случае лучше использовать робастную оценку ковариации, чтобы гарантировать, что оценка устойчива к "ошибочным" наблюдениям в наборе данных. [1], [2]

Оценщик минимального определителя ковариации#

Оценщик Minimum Covariance Determinant является робастным с высокой точкой разрушения (т.е. его можно использовать для оценки ковариационной матрицы сильно загрязнённых наборов данных, вплоть до \(\frac{n_\text{samples} - n_\text{features}-1}{2}\) выбросов) оценщика ковариации. Идея состоит в том, чтобы найти \(\frac{n_\text{samples} + n_\text{features}+1}{2}\) наблюдения, эмпирическая ковариация которых имеет наименьший определитель, давая «чистое» подмножество наблюдений для вычисления стандартных оценок местоположения и ковариации. После шага коррекции, направленного на компенсацию того факта, что оценки были получены только из части исходных данных, мы получаем устойчивые оценки местоположения и ковариации набора данных.

Оценщик Minimum Covariance Determinant (MCD) был представлен P.J.Rousseuw в [3].

Оценка#

В этом примере мы сравниваем ошибки оценки, которые возникают при использовании различных типов оценок местоположения и ковариации на зашумленных наборах данных с гауссовским распределением:

Среднее значение и эмпирическая ковариация полного набора данных, которые нарушаются, как только в наборе данных появляются выбросы

Устойчивый MCD, который имеет низкую ошибку при условии \(n_\text{samples} > 5n_\text{features}\)

Среднее значение и эмпирическая ковариация наблюдений, которые известны как хорошие. Это можно рассматривать как «идеальную» оценку MCD, поэтому можно доверять нашей реализации, сравнивая с этим случаем.

Ссылки#

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

import matplotlib.font_manager

import matplotlib.pyplot as plt

import numpy as np

from sklearn.covariance import EmpiricalCovariance, MinCovDet

# example settings

n_samples = 80

n_features = 5

repeat = 10

range_n_outliers = np.concatenate(

(

np.linspace(0, n_samples / 8, 5),

np.linspace(n_samples / 8, n_samples / 2, 5)[1:-1],

)

).astype(int)

# definition of arrays to store results

err_loc_mcd = np.zeros((range_n_outliers.size, repeat))

err_cov_mcd = np.zeros((range_n_outliers.size, repeat))

err_loc_emp_full = np.zeros((range_n_outliers.size, repeat))

err_cov_emp_full = np.zeros((range_n_outliers.size, repeat))

err_loc_emp_pure = np.zeros((range_n_outliers.size, repeat))

err_cov_emp_pure = np.zeros((range_n_outliers.size, repeat))

# computation

for i, n_outliers in enumerate(range_n_outliers):

for j in range(repeat):

rng = np.random.RandomState(i * j)

# generate data

X = rng.randn(n_samples, n_features)

# add some outliers

outliers_index = rng.permutation(n_samples)[:n_outliers]

outliers_offset = 10.0 * (

np.random.randint(2, size=(n_outliers, n_features)) - 0.5

)

X[outliers_index] += outliers_offset

inliers_mask = np.ones(n_samples).astype(bool)

inliers_mask[outliers_index] = False

# fit a Minimum Covariance Determinant (MCD) robust estimator to data

mcd = MinCovDet().fit(X)

# compare raw robust estimates with the true location and covariance

err_loc_mcd[i, j] = np.sum(mcd.location_**2)

err_cov_mcd[i, j] = mcd.error_norm(np.eye(n_features))

# compare estimators learned from the full data set with true

# parameters

err_loc_emp_full[i, j] = np.sum(X.mean(0) ** 2)

err_cov_emp_full[i, j] = (

EmpiricalCovariance().fit(X).error_norm(np.eye(n_features))

)

# compare with an empirical covariance learned from a pure data set

# (i.e. "perfect" mcd)

pure_X = X[inliers_mask]

pure_location = pure_X.mean(0)

pure_emp_cov = EmpiricalCovariance().fit(pure_X)

err_loc_emp_pure[i, j] = np.sum(pure_location**2)

err_cov_emp_pure[i, j] = pure_emp_cov.error_norm(np.eye(n_features))

# Display results

font_prop = matplotlib.font_manager.FontProperties(size=11)

plt.subplot(2, 1, 1)

lw = 2

plt.errorbar(

range_n_outliers,

err_loc_mcd.mean(1),

yerr=err_loc_mcd.std(1) / np.sqrt(repeat),

label="Robust location",

lw=lw,

color="m",

)

plt.errorbar(

range_n_outliers,

err_loc_emp_full.mean(1),

yerr=err_loc_emp_full.std(1) / np.sqrt(repeat),

label="Full data set mean",

lw=lw,

color="green",

)

plt.errorbar(

range_n_outliers,

err_loc_emp_pure.mean(1),

yerr=err_loc_emp_pure.std(1) / np.sqrt(repeat),

label="Pure data set mean",

lw=lw,

color="black",

)

plt.title("Influence of outliers on the location estimation")

plt.ylabel(r"Error ($||\mu - \hat{\mu}||_2^2$)")

plt.legend(loc="upper left", prop=font_prop)

plt.subplot(2, 1, 2)

x_size = range_n_outliers.size

plt.errorbar(

range_n_outliers,

err_cov_mcd.mean(1),

yerr=err_cov_mcd.std(1),

label="Robust covariance (mcd)",

color="m",

)

plt.errorbar(

range_n_outliers[: (x_size // 5 + 1)],

err_cov_emp_full.mean(1)[: (x_size // 5 + 1)],

yerr=err_cov_emp_full.std(1)[: (x_size // 5 + 1)],

label="Full data set empirical covariance",

color="green",

)

plt.plot(

range_n_outliers[(x_size // 5) : (x_size // 2 - 1)],

err_cov_emp_full.mean(1)[(x_size // 5) : (x_size // 2 - 1)],

color="green",

ls="--",

)

plt.errorbar(

range_n_outliers,

err_cov_emp_pure.mean(1),

yerr=err_cov_emp_pure.std(1),

label="Pure data set empirical covariance",

color="black",

)

plt.title("Influence of outliers on the covariance estimation")

plt.xlabel("Amount of contamination (%)")

plt.ylabel("RMSE")

plt.legend(loc="center", prop=font_prop)

plt.tight_layout()

plt.show()

Общее время выполнения скрипта: (0 минут 2.731 секунды)

Связанные примеры

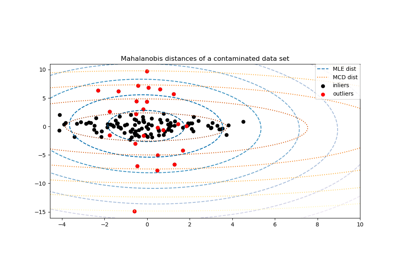

Робастная оценка ковариации и релевантность расстояний Махаланобиса

Линейный и квадратичный дискриминантный анализ с эллипсоидом ковариации