Примечание

Перейти в конец чтобы скачать полный пример кода или запустить этот пример в браузере через JupyterLite или Binder.

Эффект преобразования целей в регрессионной модели#

В этом примере мы даем обзор

TransformedTargetRegressor. Мы используем два примера,

чтобы проиллюстрировать преимущество преобразования целей перед обучением линейной

регрессионной модели. Первый пример использует синтетические данные, а второй

пример основан на наборе данных о жилье в Эймсе.

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

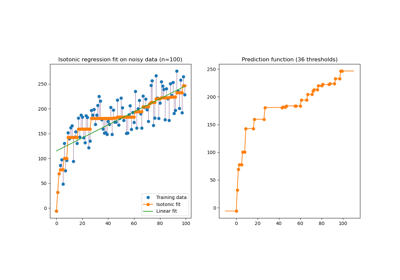

Синтетический пример#

Генерируется синтетический случайный набор данных для регрессии. Целевые переменные y изменяются:

преобразование всех целей так, чтобы все записи были неотрицательными (путем добавления абсолютного значения наименьшего

y) иприменяя экспоненциальную функцию для получения нелинейных целевых переменных, которые не могут быть аппроксимированы с помощью простой линейной модели.

Следовательно, логарифмическая (np.log1p) и экспоненциальная функция

(np.expm1) будет использоваться для преобразования целевых переменных перед обучением линейной

регрессионной модели и её использования для предсказания.

import numpy as np

from sklearn.datasets import make_regression

X, y = make_regression(n_samples=10_000, noise=100, random_state=0)

y = np.expm1((y + abs(y.min())) / 200)

y_trans = np.log1p(y)

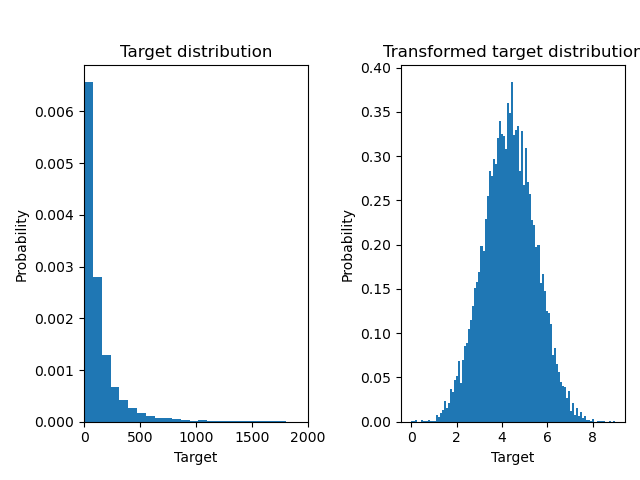

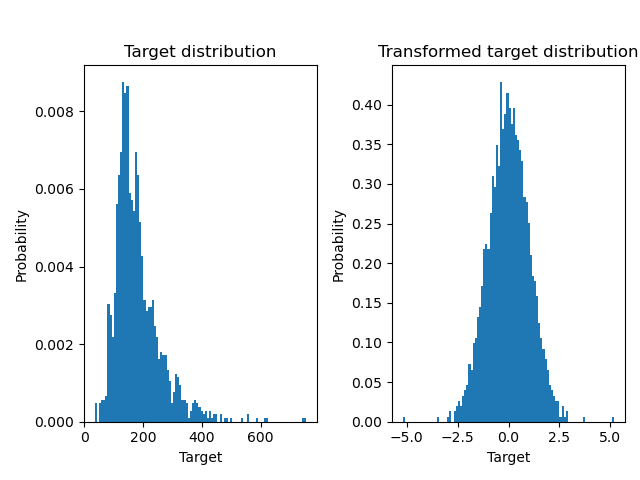

Ниже мы строим графики функций плотности вероятности целевой переменной до и после применения логарифмических функций.

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

f, (ax0, ax1) = plt.subplots(1, 2)

ax0.hist(y, bins=100, density=True)

ax0.set_xlim([0, 2000])

ax0.set_ylabel("Probability")

ax0.set_xlabel("Target")

ax0.set_title("Target distribution")

ax1.hist(y_trans, bins=100, density=True)

ax1.set_ylabel("Probability")

ax1.set_xlabel("Target")

ax1.set_title("Transformed target distribution")

f.suptitle("Synthetic data", y=1.05)

plt.tight_layout()

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=0)

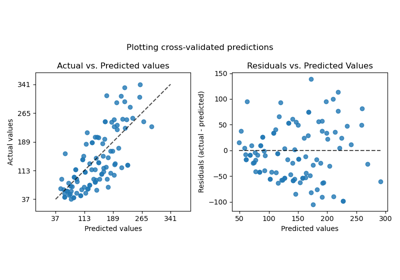

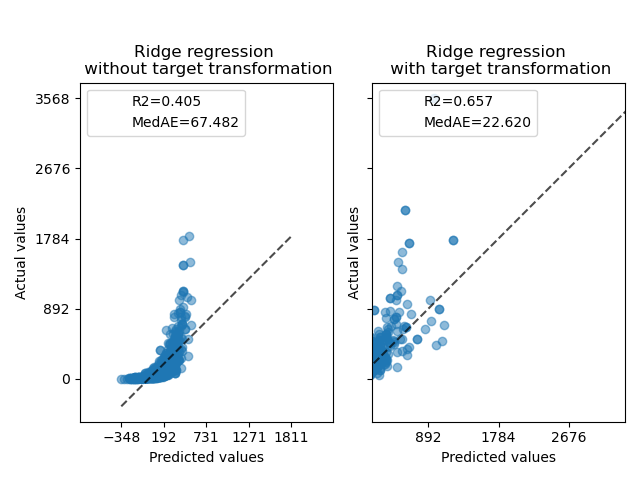

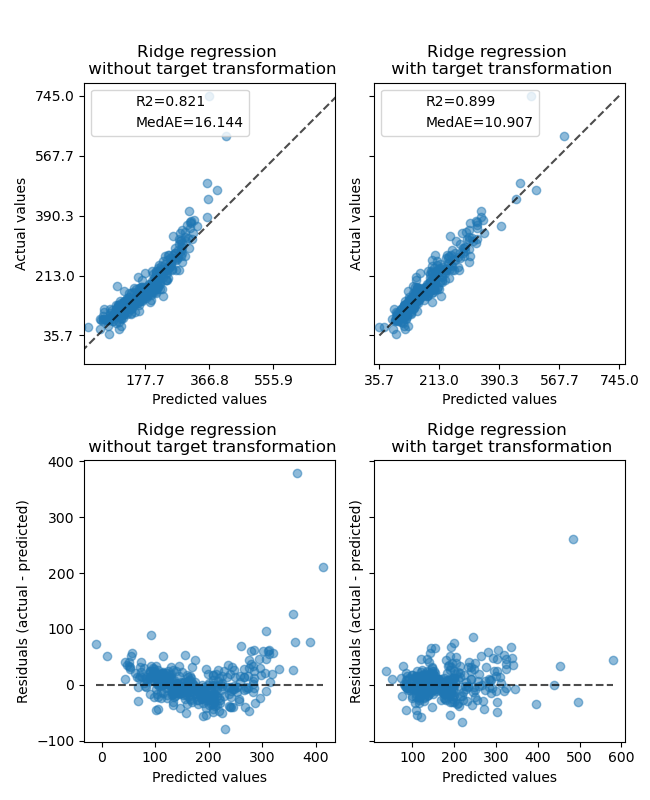

Сначала линейная модель будет применена к исходным целевым значениям. Из-за нелинейности модель, обученная таким образом, не будет точной во время предсказания. Затем логарифмическая функция используется для линеаризации целевых значений, что позволяет улучшить предсказание даже с аналогичной линейной моделью, как показано медианной абсолютной ошибкой (MedAE).

from sklearn.metrics import median_absolute_error, r2_score

def compute_score(y_true, y_pred):

return {

"R2": f"{r2_score(y_true, y_pred):.3f}",

"MedAE": f"{median_absolute_error(y_true, y_pred):.3f}",

}

from sklearn.compose import TransformedTargetRegressor

from sklearn.linear_model import RidgeCV

from sklearn.metrics import PredictionErrorDisplay

f, (ax0, ax1) = plt.subplots(1, 2, sharey=True)

ridge_cv = RidgeCV().fit(X_train, y_train)

y_pred_ridge = ridge_cv.predict(X_test)

ridge_cv_with_trans_target = TransformedTargetRegressor(

regressor=RidgeCV(), func=np.log1p, inverse_func=np.expm1

).fit(X_train, y_train)

y_pred_ridge_with_trans_target = ridge_cv_with_trans_target.predict(X_test)

PredictionErrorDisplay.from_predictions(

y_test,

y_pred_ridge,

kind="actual_vs_predicted",

ax=ax0,

scatter_kwargs={"alpha": 0.5},

)

PredictionErrorDisplay.from_predictions(

y_test,

y_pred_ridge_with_trans_target,

kind="actual_vs_predicted",

ax=ax1,

scatter_kwargs={"alpha": 0.5},

)

# Add the score in the legend of each axis

for ax, y_pred in zip([ax0, ax1], [y_pred_ridge, y_pred_ridge_with_trans_target]):

for name, score in compute_score(y_test, y_pred).items():

ax.plot([], [], " ", label=f"{name}={score}")

ax.legend(loc="upper left")

ax0.set_title("Ridge regression \n without target transformation")

ax1.set_title("Ridge regression \n with target transformation")

f.suptitle("Synthetic data", y=1.05)

plt.tight_layout()

Набор данных реального мира#

Аналогичным образом, набор данных о жилье в Эймсе используется для демонстрации влияния преобразования целевых переменных перед обучением модели. В этом примере целевая переменная для предсказания — это цена продажи каждого дома.

from sklearn.datasets import fetch_openml

from sklearn.preprocessing import quantile_transform

ames = fetch_openml(name="house_prices", as_frame=True)

# Keep only numeric columns

X = ames.data.select_dtypes(np.number)

# Remove columns with NaN or Inf values

X = X.drop(columns=["LotFrontage", "GarageYrBlt", "MasVnrArea"])

# Let the price be in k$

y = ames.target / 1000

y_trans = quantile_transform(

y.to_frame(), n_quantiles=900, output_distribution="normal", copy=True

).squeeze()

A QuantileTransformer используется для нормализации распределения целевой переменной перед применением

RidgeCV модель.

f, (ax0, ax1) = plt.subplots(1, 2)

ax0.hist(y, bins=100, density=True)

ax0.set_ylabel("Probability")

ax0.set_xlabel("Target")

ax0.set_title("Target distribution")

ax1.hist(y_trans, bins=100, density=True)

ax1.set_ylabel("Probability")

ax1.set_xlabel("Target")

ax1.set_title("Transformed target distribution")

f.suptitle("Ames housing data: selling price", y=1.05)

plt.tight_layout()

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=1)

Эффект трансформера слабее, чем на синтетических данных. Однако, преобразование приводит к увеличению \(R^2\) и значительное уменьшение MedAE. График остатков (предсказанная цель - истинная цель в зависимости от предсказанной цели) без преобразования цели принимает изогнутую форму 'обратной улыбки' из-за значений остатков, которые варьируются в зависимости от значения предсказанной цели. С преобразованием цели форма более линейная, что указывает на лучшее соответствие модели.

from sklearn.preprocessing import QuantileTransformer

f, (ax0, ax1) = plt.subplots(2, 2, sharey="row", figsize=(6.5, 8))

ridge_cv = RidgeCV().fit(X_train, y_train)

y_pred_ridge = ridge_cv.predict(X_test)

ridge_cv_with_trans_target = TransformedTargetRegressor(

regressor=RidgeCV(),

transformer=QuantileTransformer(n_quantiles=900, output_distribution="normal"),

).fit(X_train, y_train)

y_pred_ridge_with_trans_target = ridge_cv_with_trans_target.predict(X_test)

# plot the actual vs predicted values

PredictionErrorDisplay.from_predictions(

y_test,

y_pred_ridge,

kind="actual_vs_predicted",

ax=ax0[0],

scatter_kwargs={"alpha": 0.5},

)

PredictionErrorDisplay.from_predictions(

y_test,

y_pred_ridge_with_trans_target,

kind="actual_vs_predicted",

ax=ax0[1],

scatter_kwargs={"alpha": 0.5},

)

# Add the score in the legend of each axis

for ax, y_pred in zip([ax0[0], ax0[1]], [y_pred_ridge, y_pred_ridge_with_trans_target]):

for name, score in compute_score(y_test, y_pred).items():

ax.plot([], [], " ", label=f"{name}={score}")

ax.legend(loc="upper left")

ax0[0].set_title("Ridge regression \n without target transformation")

ax0[1].set_title("Ridge regression \n with target transformation")

# plot the residuals vs the predicted values

PredictionErrorDisplay.from_predictions(

y_test,

y_pred_ridge,

kind="residual_vs_predicted",

ax=ax1[0],

scatter_kwargs={"alpha": 0.5},

)

PredictionErrorDisplay.from_predictions(

y_test,

y_pred_ridge_with_trans_target,

kind="residual_vs_predicted",

ax=ax1[1],

scatter_kwargs={"alpha": 0.5},

)

ax1[0].set_title("Ridge regression \n without target transformation")

ax1[1].set_title("Ridge regression \n with target transformation")

f.suptitle("Ames housing data: selling price", y=1.05)

plt.tight_layout()

plt.show()

Общее время выполнения скрипта: (0 минут 1.218 секунд)

Связанные примеры

Конвейеризация: объединение PCA и логистической регрессии